Lügendetektor für Social Media-Inhalte

Wie können Inhalte aus Social Media auf ihre Glaubwürdigkeit überprüft werden? Immer wieder steht diese Frage im Raum. Längst reicht eine händische Recherche bei der unüberblickbaren Fülle an Informationen im Netz nicht mehr aus. Umso wichtiger werden maschinelle Auswertungsmethoden. Eine Software basierend auf solchen Methoden will ein Forscherteam aus sieben Ländern nun entwickeln – ein hoch gestecktes Ziel.

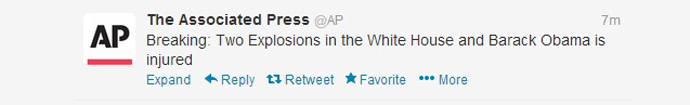

Es war im April 2013, als die Nachrichtenagentur AP auf Twitter verkündete, im Weissen Haus sei es soeben zu zwei Explosionen gekommen. Auch der amerikanische Präsident sei dabei verletzt worden.

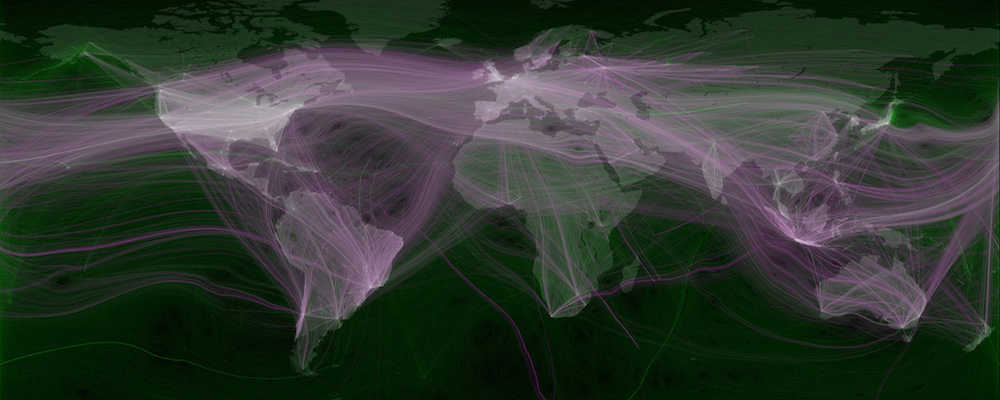

Dabei handelte es sich um eine der bisher grösseren Twitter-Falschinformationen, die sich innerhalb kürzester Zeit auf der ganzen Welt verbreitet haben. Doch nicht nur völlig frei erfundene Nachrichten verbreiten sich als so genannte Hoaxes, sondern auch teilweise fehlerhafte Details während Breaking News, die tatsächlich stattfinden.

Mit dem Aufkommen von Social Media und der erhöhten Nachrichtentaktung half in den letzten Jahren einzig die händische Recherche von geschulten Journalisten diesem Phänomen entgegenzutreten. Mit technischen Tools und der nötigen Zeit konnten die meisten Fehler in der hitzigen Berichterstattung aufgedeckt und korrigiert werden. Bei immer mehr Informationen und mit zunehmender Hektik sind Journalisten allerdings auf ausgeklügelte Analyse-Software angewiesen.

Verifikation mit minimalem Aufwand

Ein Konsortium von Forschern aus Österreich, Deutschland, England, Bulgarien, Spanien, Kenia und der Schweiz will nun eine solche Software im Rahmen eines EU-Forschungsprojektes entwickeln und anbieten. Ziel dieses dreijährigen Projektes soll sein, mit möglichst minimalem Ressourcen-Aufwand die Vertrauenswürdigkeit von Social-Media-Inhalten besser beurteilen zu können.

Da sich die inhaltliche Analyse als schwieriges Unterfangen offenbart, wollen sich die Forscher in erster Linie linguistischen und grafischen Untersuchungsmethoden bedienen. Dabei stützen sie sich auf die vier Vs der Big Data-Analyse:

- volume (Aufkommen der Information)

- variety (Vielfalt der unterschiedlichen Informationen)

- velocity (Geschwindigkeit der Informationsausbreitung)

- veracity (Glaubwürdigkeit der Information)

Bei dem Projekt namens «Pheme» wollen die Forscher vor allem den letztgenannten Punkt, die Glaubwürdigkeit der verbreiteten Information, untersuchen. Die fehlerhafte Berichterstattung wird von den Wissenschaftlern unterteilt und zwar in Spekulation, kontroverse Inhalte, Falsch- und Fehlinformation. Diese Untersuchung ist allerdings bei weitem nicht nur auf News-Meldungen ausgerichtet. Mit der entwickelten Software wollen die Forscher auch Gerüchte aus dem Medizin- und Klimabereich analysieren.

Unwahrheiten früher erkennen, Panik vermeiden

Die Wissenschaftler erhoffen sich aufgrund der neu gewonnenen Erkenntnisse, Rückschlüsse zur Verbreitung von Gerüchten und Fehlinformationen ziehen zu können. Somit möchte man Unwahrheiten und womöglich sogar Panik-Ausbrüche früher erkennen und präventiv vermeiden. Dazu arbeitet das «Pheme»-Team auch mit Partnern aus der Medienbrachen zusammen, wie etwa der BBC, dem SWR oder swissinfo.

Der Wunsch nach automatisierten Verifikationstechnologien ist nicht neu. Allerdings ist es bisher noch keinem Entwicklerteam gelungen, die riesige Menge an Informationen maschinell sinnvoll zu filtern und mit den entsprechenden Algorithmen zu untersuchen. Das Ziel des vorliegenden Forschungsprojektes ist entsprechend hoch gesteckt.

(Hinweis via Jonas Jansen, Artikelbild via Fast Company)

Inhaltsverzeichnis